英伟达和对手互相比“芯”?微软不甘心吃瓜看戏!

时间:2018-09-06 来源:互联网 浏览量:

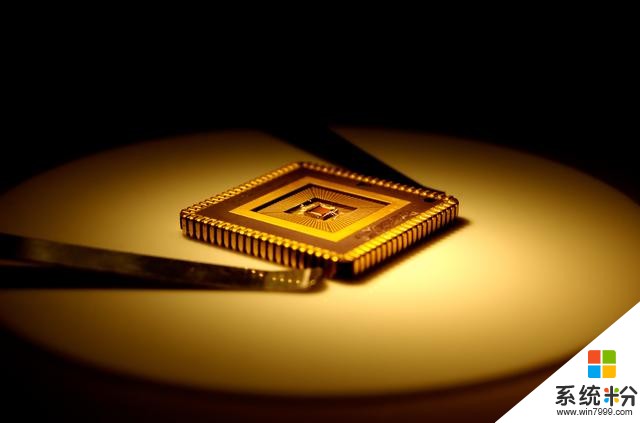

随着人工智能、深度学习的普及火爆,各类芯片名词GPU, TPU, DPU, NPU, BPU陆续出现在人们的视野,这些都是什么鬼?!

CPU:Central Processing Unit, 即中央处理器;

GPU:Graphics Processing Unit, 即图像处理器;

TPU:Tensor Processing Unit, 即张量处理器;

DPU:Deep learning Processing Unit, 即深度学习处理器;

NPU:Neural network Processing Unit, 即神经网络处理器;

BPU:Brain Processing Unit, 即大脑处理器。

人工智能旨在为机器赋予人的智能,机器学习是实现人工智能的强有力方法。我们现在所说的AI芯片指的是是专门针对AI算法做了特殊加速设计的芯片。

芯片巨头Nvidia(英伟达)已经牢牢占据AI芯片榜首,由于CUDA开发平台的普及,英伟达的GPU是目前应用最广的通用AI硬件计算平台。除了有实力自研芯片的企业(全世界也没几家),如果需要做AI相关的工作,必定需要用到Nvidia的芯片。Nvidia的芯片应用普遍,现在所有的AI软件库都支持使用CUDA加速,包括谷歌的Tensorflow,Facebook的Caffe,亚马逊的MXNet等。Intel通过买、买、买奋力的将自己挤到了头部玩家的位置。英特尔是PC芯片的霸主,但其向AI的转型相对较晚。但在决定向AI转型后十分积极,一方面通过优化自身已有优势产品,另一方面还通过一系列的收购增强实力

微软在最新的Build大会上公布了基于英特尔FPGA的AI方案,而英特尔的FPGA业务正是通过收购Altera获得的。不过我们也发现,像Google这样的互联网企业也突然做起了芯片。

谷歌宣布其Tensor处理单元(TPU) - 一种为搜索,街景,谷歌照片和谷歌翻译等谷歌服务的神经网络计算提供支持的定制芯片 - 现已面向谷歌云研究人员和开发人员提供测试版平台。

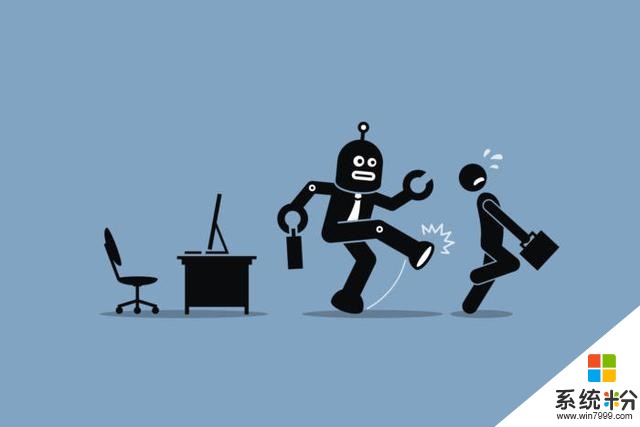

TPU是针对TensorFlow上的机器学习工作负载量身定制的定制应用专用集成电路(ASIC)。 谷歌两年前推出了TPU,并于去年发布了第二代云TPU。 虽然第一代TPU仅用于推理,但Cloud TPU适用于推理和机器学习培训。 Cloud TPU采用四个定制ASIC构建,可提供强大的64 GB高带宽内存和180 TFLOPS性能。

在向公众开放TPU之前,谷歌已在内部广泛实施。 AlphaGo--在中国古代棋盘游戏Go中击败人类冠军的Google AI杰作 - 使用了48个TPU进行推理。

Cloud TPU为缩短机器学习模型的培训时间提供了一个很好的解决方案。谷歌大脑团队负责人杰夫迪恩在Twitter上发布推文说,云TPU可以在24小时内将ResNet-50模型的准确率提高到75%。

当Cloud TPU宣布时,谷歌为机器学习研究人员提供了1000个免费设备。 Lyft是美国第二大乘车公司,自去年以来一直在其自动驾驶系统中使用云TPU。该公司的软件自驾游级别负责人Anantha Kancherla表示,“自从与Google Cloud TPU合作以来,我们对他们的速度印象非常深刻 - 通常需要几天时间才能花费数小时。”

总部位于纽约市的对冲基金Two Sigma首席技术官Alfred Spector表示,“我们发现将TensorFlow工作负载转移到TPU可以大大降低编程新模型的复杂性和培训所需的时间,从而提高了我们的生产力。”

Google的Cloud TPU目前仅处于测试阶段,提供的数量和使用量有限。开发人员可以以6.50美元/云TPU /小时的价格租用云TPU,考虑到其出色的计算能力,这似乎是一个合理的价格。

谷歌还发布了几个模型实现工具,以节省开发人员为云TPU编写程序的时间和精力,包括ResNet-50和其他流行的图像分类模型,机器翻译和语言建模的变换器,以及用于对象检测的RetinaNet。

虽然谷歌目前没有直接向客户销售其TPU芯片,但它们的可用性对Nvidia来说是一个挑战,Nvidia的GPU目前是世界上最常用的AI加速器。甚至谷歌也使用大量的Nvidia GPU来提供加速的云计算服务。然而,如果研究人员按照预期从GPU切换到TPU,这将减少谷歌对Nvidia的依赖。

去年,谷歌宣称它的TPU比现代GPU和推理CPU快15到30倍,并且TOPS / Watt测量值提高了30-80倍。在机器学习培训中,云TPU的性能更强(180对120 TFLOPS),内存容量(64 GB对16 GB内存)比Nvidia最好的GPU Tesla V100大四倍。尽管将云TPU称为AI芯片冠军还为时尚早,但其可用性的宣布引起了研究人员的兴奋,并标志着谷歌雄心勃勃地进入AI加速器领域的开始。

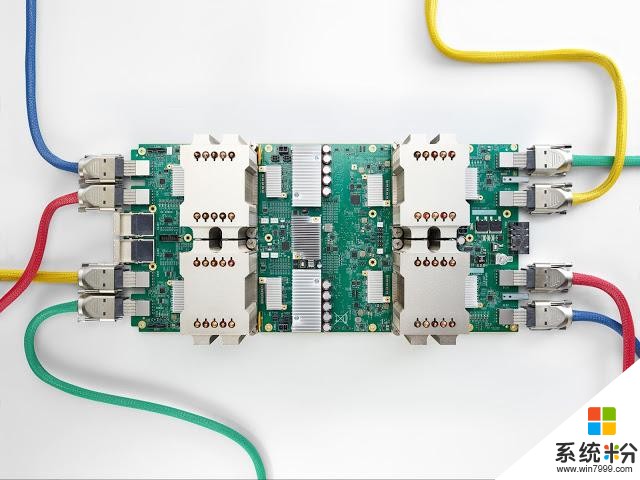

此外,谷歌还发布了Edge TPU,特定用途 ASIC 芯片,专为在设备上运行 TensorFlow Lite ML 模型而设计。Edge TPU 可以加速设备上的 ML 推理,或与 Google Cloud 配对,创建完整的云到边缘 ML 堆栈。针对Edge TPU的新设备是:AIY Edge TPU Dev 开发板和 AIY Edge TPU 加速器,二者皆采用 Google 的 Edge TPU 芯片。

基本上不仅以前的硬件巨头,包括诸如亚马逊、Facebook等互联网巨头都在涉足人工智能芯片。

作为电商巨头,亚马逊在硬件领域的实力则弱很多,因此在AI的竞争中更加倾向于通过收购AI芯片初创公司让AI芯片更快服务自己的生态。Information爆料称,亚马逊已经开始设计定制AI芯片的消息基本坐实。英特尔是All In AI,除了收购,英特尔还投资了一系列的芯片企业,包括Lyncean Technologies、Movellus、SiFive。

微软则更多通过合作进入AI芯片市场,微软设备部门全球副总裁Panos Panay在2017年接受CNBC采访时确认了微软正在为下一代HoloLens MR头戴设备研发AI芯片,表示微软不仅拥有一支专注的IC设计团队,而且还与芯片制造商和其他合作伙伴共同开发。

目前国内做AI芯片的公司可能有几十家,重合度不会低。但多数公司有自己的侧重点,例如寒武纪主推自己的AI专用处理器,地平线机器人在自动驾驶方面发展较多,商汤在智能监控方面积累较好。