微软首席人工智能科学家邓力离职 加盟对冲基金Citadel

时间:2017-05-19 来源:互联网 浏览量:

他在和机器之心确认GMIS 2017 大会有关他信息的邮件中写道:「我最近已经离开了微软的岗位,加入了一家新的美国公司Citadel——世界上最成功的投资公司之一。Citadel 在人工智能创新上的机遇及对增进公司在该领域领导地位的热情让我倍感振奋。」

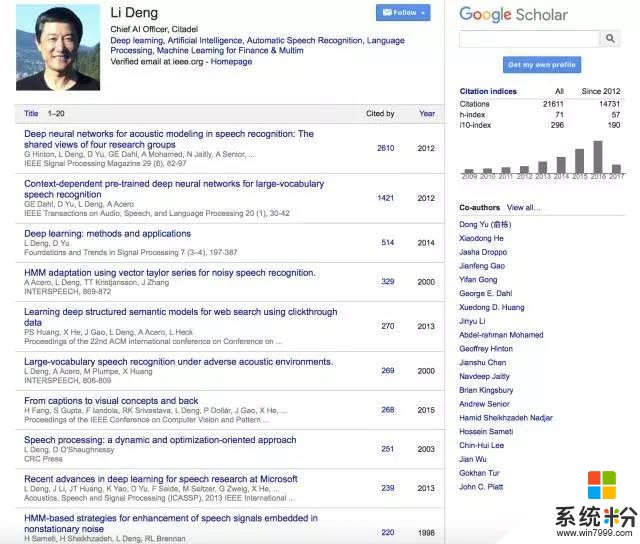

作为深度学习、人工智能、自然语言理解与语音识别方面的专家,邓力早在2009 年就同Geoffrey Hinton 教授合作,首次提出并将深度神经网络应用到大规模语言识别中,显著提高了机器对语音的识别率,极大推动了人机交互领域的发展与进步。目前,邓力的研究方向主要为应用于大数据、语音、文本、图像和多模态处理的深度学习和机器智能方法。在语音、NLP、大数据分析、企业智能、互联网搜索、机器智能、深度学习等领域,邓力曾获70 多项美国或国际专利。同时,他还获得过IEEE、国际言语通讯协会、美国声学协会、亚太信号与信息处理协会、微软等组织授予的多项荣誉。2015 年,凭借在深度学习与自动语音识别方向做出的杰出贡献,邓力获IEEE 技术成就奖。

Citadel 是全球最大的多策略对冲基金之一,目前掌管至少260 亿美元资产,以其量化交易策略及程序化交易系统出名。在美国,Citadel 还是最大的期权交易机构和经纪交易商之一。相比其巨额资产管理规模和高杠杆,Citadel 更引人注目的是拥有华尔街「最大牌」的「金融顾问」——前美联储主席伯南克。

Citadel 去年雇佣了来自德意志银行、专注机器学习的量化交易专家Christian Hesse。其它全球著名对冲基金如Man Group、Winton 、Aspect Capital 也在充实自己的机器学习专家队伍。

以下是机器之心对邓力的研究历程所做的梳理:

1978-1982 年邓力本科就读于中科大,学习神经科学和生物物理学专业。1982 年前往美国研究听觉神经系统与其计算模型。

1984-1986 年在完成博士论文期间,他用物理模型和神经模型来做人类听觉模拟和语音识别。但受当时的客观条件限制,神经网络运算速度太慢。他也尝试过提取生物模型特征加入隐马尔科夫模型里,结果同样不理想,因为两者并非成熟的、可匹配的系统。后来,他发现纯统计方法更有效。因此从80 年代中末期至深度学习爆发前,邓力一直在做包括统计模型和计算人工神经网络在内的相关研究。

1993-1994 年左右在加拿大滑铁卢大学任职教授期间,邓力和他的一位博士生合作了一篇论文:当把线性项加到非线性项之后,可以增强神经网络的记忆能力。他做了很多数学上的推演,来分析为何记忆能力可以得到增强。虽然当时的计算机的计算力不够,模型也很简单,但这已经是一套完整的系统。当他们把这个结果真正用在语音识别上时,却还是没能获得大大超过隐马尔科夫模型的性能。这位博士生论文的External Examiner 是Geoffrey Hinton,他看过论文后表示「神经网络成功真是太难了」。虽然博士生拿到了博士学位,但这次研究的结果让邓力暂时放下了神经网络的研究,开始转向贝叶斯统计方法和生成模型(Generative Models)。

1999 年底,邓力放弃滑铁卢大学的终身正教授职位正式加入微软美国研究院,主攻语音识别和机器学习方向。在有效的深层神经网络学习方法发明之前,他用贝叶斯网络方法把隐马尔科夫模型(顶层)和人类语音生成模型相结合,并设计了很多层次,以期将重要的物理现象模拟出来。隐马尔科夫模型只是模拟了大脑对语音符号编码的行为,但整个语音生成过程中还包括肌肉运动控制、口腔内声道运动等环节,最后通过声学转化才能变成语音,这就需要包括对噪音环境的模拟等在内的许多层次。这种多层结构能自然地用深层生成模型来实现。

2002 至2006 年期间,邓力在微软领导一支团队在这方面做了很多研究工作,当时相对有效的机器学习工具是贝叶斯网络等方法。但如果隐含变量层数很多,并且在动态过程中进行语音识别,它的学习和推断过程很难驾驭,增加层数后带来的计算复杂度呈指数级增长。他们发明了很多方法来近似指数级增长的计算,近似之后结果还不错,但与精心设计和调制的隐马尔科夫模型相比,准确率上并没有非常大的进步。

后来,邓力了解到Hinton 2006 年关于深度信念网络的论文(注:《A fast learning algorithm for deep belief nets》),其模型也是有很多层的生成式的结构,但却并没有出现计算复杂度无法驾驭的问题。

2009 年,邓力请Hinton 作为他的顾问来微软深入讨论这些问题,他们发现深度信念网络比较容易的原因之一是它不涉及动态。因此邓力和研究团队把严谨的动态模型暂时去掉,将时域上相邻的向量数加大来近似严谨的动态模型。最后得到的简化模型就成为目前著名的深度神经网络。同时,邓力和Hinton 同他们的同事与学生合作把隐马尔科夫模型和深度神经网络结合起来。

2010-2011 年邓力和团队在微软经过大规模的实验后,使得深度神经网络在工业界的大型语音识别上取得了革命性的突破。在此期间及随后数年,邓力每年都抽空到中国演讲深度学习,语音语言处理和人工智能,包括微软亚洲研究院,中科大,清华,北大,讯飞,台湾中研院,以及IEEE 和其他协会组织的会议。

2011 年之后,邓力和团队继续对深度神经网络做了一系列的改进,包括引入深度LSTM 循环网络,深度CNN 和新型的学习方法,例如sequence learning 和ensemble learning。这些创新继续大幅提高语音识别准确度,并成功将之整合入语音理解和语音翻译。

2014 年初,邓力在微软创立Deep Learning Technology Center(DLTC)。2016 年初,微软执行副总裁陆奇任命他为首席人工智能科学家。自2014 年初,邓力组建并带领全新并日益增大的DLTC 团队将深度学习的成功从语音识别,理解和翻译扩展到公司多方面的业务。这包括基于DSSM,LSTM 和记忆网络的互联网(Bing)搜索和问答,电子邮件及企业文件搜索,聊天和对话机器人,具备解释性和深度学习高效能的机器阅读/问答/翻译,多模态深度学习,看图说话,市场和销售数据的深度学习及商业应用,等等。同时也在公司内培养的一大批精通深度学习的工程师和研究人员。

2016 下半年,微软执行副总裁沈向阳任命邓力为微软人工智能学院(AI School)的总负责人组建学院。经过几个月的努力,学院建成并于2017 四月底成功毕业了一批来源于美国微软工程师的首届学员。

相关资讯

最新热门游戏

微软资讯推荐

- 1 上了SSD固态盘的Win10还卡?试试这个提速妙招

- 2 微软OneDrive扩容计划开放购买,每月最低1.99美元

- 3 微软宣布继续为Windows 7企业级用户提供支持!

- 4微软仍在开发手机? Surface Phone或可折叠的机型

- 5微软从头再来两年后或再放大招

- 6Windows 10X有望下半年推出:动态壁纸功能对硬件配置提出新考验

- 77688元,微软Win10 S笔电Surface Laptop国行版发布

- 8Windows神软Classic Shell停更!经典开始菜单永别了

- 9Office 2019预览版轻体验:这就是微软的杀招?

- 10游戏开发商称微软将于2020年发布两款Xbox游戏主机