NVIDIA联手Arm开启HPC新生态!微软Azure启动GPU超算实例

时间:2019-11-20 来源:互联网 浏览量:

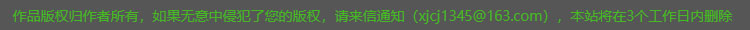

芯潮11月20日消息,昨天,英伟达在2019国际超级计算大会(SC19)上推出用于构建GPU加速Arm服务器的参考设计,以及用于优化网络和存储数据处理的Magnum IO软件套件。

与此同时,英伟达创始人兼CEO黄仁勋宣布,微软已在Azure云计算平台上构建了NDv2超大型实例,专为AI和HPC应用而构建,是全球最大的GPU加速的云端超级计算机之一 。

值得一提的是,Magnum IO软件套件主要针对当下市场的数据处理需求,能够帮助研究人员在数分钟内处理大量复杂的数据,数据迁移速度比以往提升20倍。

此外,黄仁勋还在现场发表演讲,针对AI、图像和高性能计算等技术的行业现状,以及目前业内的最新发展动态,阐释了他对HPC领域未来广阔的发展前景。

“高性能计算领域正在同时朝各个方向扩展。实际上,高性能计算已无处不在,比如超级计算中心、云和边缘等。”他说到。

一、GPU加速Arm服务器参考设计,满足多样化HPC需求

一、GPU加速Arm服务器参考设计,满足多样化HPC需求黄仁勋在会上预测,如今Arm已拥有超过1000亿台计算设备,而在未来几年,该数字将超过1万亿台。

随着AI和机器学习等领域的技术研发不断创新与突破,从云端到边缘端、从高性能存储到百万兆级超算等方面的高性能计算需求正在持续增长。

而英伟达此次联合Arm等科技企业推出GPU加速Arm服务器的参考设计,由英伟达和Arm、Marvell和富士通等高科技企业共同开发,能满足从云端到边缘端等多样化的高性能计算需求。

同时,该设计还将硬件和软件基础模块相结合,让超级计算中心、超大型云运营商和企业,能通过使用英伟达加速计算平台和Arm服务器平台,来进一步满足自身的技术研发和工业应用等需求。

在黄仁勋看来,英伟达和Arm等企业的合作将会形成一个优质的生态,几乎所有在高性能计算中运行的工作,都应该能够在任何CPU上运行,并且目前已有30个应用已开始启动并运行。

同时,许多高性能计算软件公司也开始使用英伟达CUDA-X库,以构建能在Arm服务器上运行,并可通过GPU实现的管理和监控工具。

此外,英伟达还与GROMACS、LAMMPS和Relion等领先的高性能计算应用开发商进一步合作,为Arm提供GPU加速的应用程序。

截至目前,英伟达已提供Arm兼容软件开发套件的预览版本,其包括英伟达CUDA-X库和加速计算开发工具。

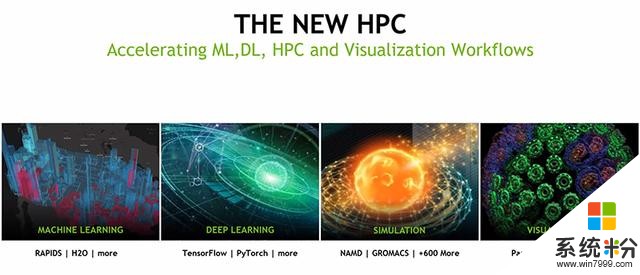

二、微软Azure云计算平台构建NDv2实例

二、微软Azure云计算平台构建NDv2实例Azure NDv2实例是专为处理要求苛刻的AI和HPC应用而构建,能够在一个Mellanox InfiniBand后端网络上,提供多达800个互联的英伟达V100 Tensor Core GPU,进一步解决当下复杂AI、机器学习和高性能计算的工作负载。

黄仁勋谈到,NDv2作为全球最快的超级计算机之一,能够使高性能计算研究者和其他人员实时获得前所未有的GPU算力。

在他看来,这是英伟达有史以来首次让用户可依据自身需求,来租用整台AI超级计算机,并且性能还可与需要长达数月部署时间的大型本地超级计算机相匹配。

此外,NDv2与其他基于CPU的传统计算机相比,其性能和性价比也有了一定的提升。

一方面,它可迅速启动多个NDv2实例,在短短几小时内完成复杂的会话式AI模型训练。例如,微软和英伟达研发人员曾使用64个NDv2实例,在三小时左右完成了BERT会话式AI模型的训练。

另一方面,它可帮助客户使用多个NDv2实例,以运行复杂的高性能计算工作负载。同时,相比专用于深度学习等特定应用程序,或未使用GPU的高性能计算节点而言,单个NDv2实例就可实现高达一个数量级的速度提升。

目前,NDv2已推出预览版本,其中一个实例包含了8个英伟达V100 GPU,以根据不同的工作负载需求进行扩展。

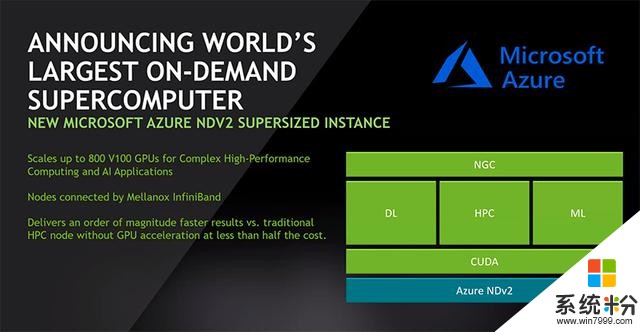

三、Magnum IO软件套件:大量数据迁移速度提升20倍

三、Magnum IO软件套件:大量数据迁移速度提升20倍近年来,随着AI等数据驱动型应用的愈加发展和成熟,大数据正在迎来爆发式增长,如何优化数据的传输和处理,已然成为数据中心所需面临的巨大挑战。

基于此,英伟达推出的Magnum IO软件套件,能将多服务器、多GPU计算节点的数据处理速度提升至20倍,帮助AI研究者和数据科学家将数据移动时间从数小时缩短至几分钟。

“Mangum IO能够为I/O与存储带来具有革命性计算性能的英伟达GPU加速。”针对Magnum IO软件套件对网络和存储领域进行的数据处理优化,黄仁勋说到。

与此同时,英伟达GPUDirect Storage是Magnum IO的一项关键功能,能为数据提供一条连通GPU内存和存储的直接数据路径,让研发人员在访问存储时绕过CPU,以快速访问用于模拟、分析和可视化的数据文件。

此外,GPUDirect可兼容多种通信互联产品与API,由点对点和RDMA组件组成。

值得注意的是,虽然Magnum IO软件套件已上市,但GPUDirect Storage暂时只为部分用户提供早期访问权限。

黄仁勋表示,英伟达计划在2020年上半年向所有客户提供GPUDirect Storage。

结语:英伟达联手科技企业为HPC领域注入新活力

结语:英伟达联手科技企业为HPC领域注入新活力不难看出,随着AI、5G和自动驾驶等技术的进一步发展与成熟,超算技术已然成为驱动大数据、云计算和深度学习算法等融合创新的重要力量之一。

而作为全球领先的GPU巨头,英伟达在持续提高产品多样化、进行市场全方位部署的同时,也在持续打入各大领域的生态系统,进一步为这些生态提供各类高性能的计算工具。

未来,随着HPC领域的愈发成熟,以及超算技术与AI和云计算等各类领域的深度结合,英伟达又将会联合科技企业为行业带来那些惊喜,十分值得我们期待。

相关资讯

- 新专利暗示微软正在打造升级版可折叠Surface Phone

- 微软新数据:运行Windows 10设备突破7亿台,小娜用户超1.5亿

- NVIDIA Volta核心升级32G显存、Quadro GV100推出

- 外媒曝NVIDIA将在下周发布新架构GeForce显卡

- NVIDIA新驱动优化《绝地求生》正式版:GTX 1060轻松60FPS

- NVIDIA TITAN V性能大公开:1080Ti无地自容

- 微软Azure数据盒 为云数据导入带来新选择

- 比亚迪与微软强强联手, 有望共同打造智能生态链!

- 2017微软技术暨生态大会: 微软Azure云服务将在华扩容3倍

- 微软、埃森哲强强联手,开启区块链全球数字身份认证计划!